El potencial uso de esta herramienta para generar imágenes hiperrealistas revive la preocupación sobre el uso malicioso de la IA para crear, reforzar y amplificar tanto narrativas desinformantes, contenidos de odio y discriminación

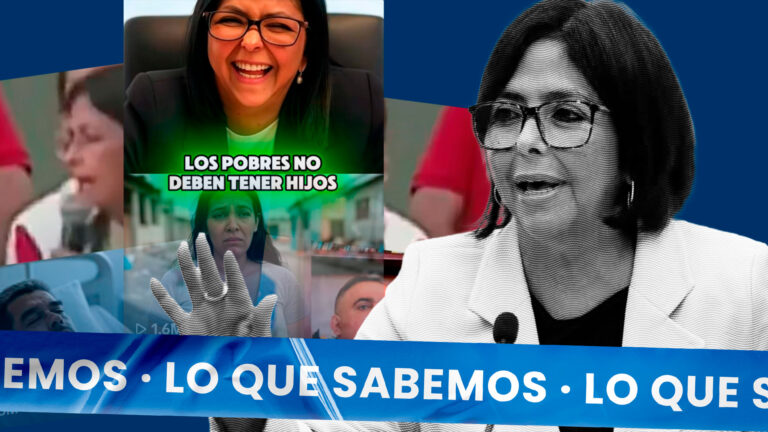

Este 11 de diciembre fueron compartidas fotos de Edmundo González Urrutia y María Corina Machado con armas de fuego o en escenarios ficticios, creadas con la herramienta de inteligencia artificial generativa llamada Aurora, incorporada al chatbot Grok, de la red social X, por un grupo de cuentas sin aparente vinculación con el gobierno de Venezuela.

La difusión de este contenido —por quienes parecen ser usuarios espontáneos experimentando con la nueva herramienta— puede ayudar a reforzar algunas narrativas desinformantes favorables al gobierno venezolano, como que ambos dirigentes opositores promueven una transición violenta, planes bélicos y acciones terroristas, acciones que han sido desmentidas por el propio González Urrutia durante los últimos meses.

Pero el posible uso malicioso de Aurora, especialmente para crear, reforzar y amplificar tanto narrativas desinformantes como contenidos de odio o discriminación, da lugar a un debate sobre la probable necesidad de su arbitraje, lo cual podría ir en contra de los argumentos defendidos por Elon Musk, propietario de X, sobre la censura y la libertad de expresión.

El pasado 7 de diciembre fue incorporado a Grok, el chatbot de la red social X, un modelo de generación de imágenes llamado Aurora, con el cual se han creado fotos de personas públicas de todo el mundo. El propietario de X, Elon Musk, informó que el sistema aún está en su fase beta.

El potencial de Aurora para crear imágenes hiperrealistas ha generado controversias sobre su alcance e influencia, especialmente por el impacto que podrían tener en la difusión de desinformación y contenido malicioso. Sin embargo, la herramienta cuenta con restricciones específicas que le impiden generar imágenes de connotación sexual explícita o de violencia, lo que busca mitigar estos riesgos.

No se trata de algo inédito

Lo ocurrido recientemente con González Urrutia y Machado no es el único caso en Venezuela de contenido creado con inteligencia artificial generativa. En 2023, «House of News», un falso noticiero en YouTube, publicó videos desinformativos usando avatares de falsos periodistas creados con IA generativa.

Ese mismo año, el director de la organización Bellingcat, Elliot Higgins, difundió fotos de un falso arresto de Donald Trump en Florida que fueron creadas con la herramienta Midjourney. Su objetivo era alertar del peligro de difundir sin contexto estas imágenes, que causaron furor en las plataformas digitales y fueron desmentidas rápidamente por redes de chequeadores.

Esto llevó a Midjourney a modificar su política de uso y sus algoritmos para evitar que los usuarios crearan nuevas fotografías no solo de Trump sino también del presidente saliente de Estados Unidos, Joe Biden, de cara a las pasadas presidenciales de noviembre y evitar la difusión de deepfakes.

La libertad de expresión en X

Elon Musk compró Twitter (ahora X) en octubre de 2022. Para entonces, dijo que la adquisición respondía a la importancia de que el mundo disponga de un espacio digital y libre de violencia para el debate de creencias de manera sana. El magnate argumentó, además, que la moderación es solo una forma de censura.

Sin embargo, algunas organizaciones denuncian lo contrario. Tal es el caso del Centro para Contrarrestar el Odio Digital (Center for Countering Digital Hate -CCDH-, en inglés), demandado en julio de 2023 por Elon Musk y X Corp. por la pérdida de millones de dólares en ingresos publicitarios, en respuesta a un informe de la ONG que concluye que los discursos de odio hacia las comunidades minoritarias aumentaron en X desde la compra de la red social.

«La demanda es un ataque directo a nuestra libertad de expresión, con el objetivo de aumentar los costos legales, distraernos de nuestro trabajo y disuadir a otros de informar sobre X».

Centro para Contrarrestar el Odio Digital

La postura de Musk, aunque defiende la libertad de expresión como un nuevo escalafón en el debate de ideas o creencias, podría resultar preocupante debido a que a través de la inteligencia artificial generativa también se puede crear y reforzar narrativas desinformantes o amplificar contenidos de odio o discriminación, por lo cual se requiere que esta herramienta esté bajo el arbitrio ético-jurídico para evitar su uso de manera maliciosa.

Cazadores de Fake News investiga a detalle cada caso, mediante la búsqueda y el hallazgo de evidencias forenses digitales en fuentes abiertas. En algunos casos, se usan datos no disponibles en fuentes abiertas con el objetivo de reorientar las investigaciones o recolectar más evidencias.