El 2023 será conocido como el año en que la inteligencia artificial (IA) se hizo accesible para todos los usuarios de Internet, a la vez que plantea nuevas inquietudes sobre su uso para desinformar

El año 2023 marcó un hito en la evolución de la inteligencia artificial, especialmente con los avances en Modelos de Lenguaje de Gran Escala (LLM, por sus siglas en inglés) como ChatGPT y Bard, así como en Redes Generativas Adversarias (GAN, por sus siglas en inglés) como Midjourney y DALL-E. Estos adelantos transformaron la manera en la que los usuarios de Internet interactúan con la inteligencia artificial, ofreciendo nuevas posibilidades y a la vez planteando nuevos retos, incluyendo preocupaciones sobre su impacto en la propagación o mitigación de la desinformación.

La capacidad de crear imágenes hiperrealistas, audios y videos con esta tecnología abre una nueva puerta a la desinformación. Sobre todo, luego de que imágenes de una bomba explotando a las puertas del Pentágono o del falso arresto de Donald Trump generadas con IA tuvieron consecuencias en “la vida real” a través de un flash crash en la bolsa de valores o promoviendo la discusión sobre el uso responsable de esta nueva herramienta.

Desinformación con IA en Venezuela

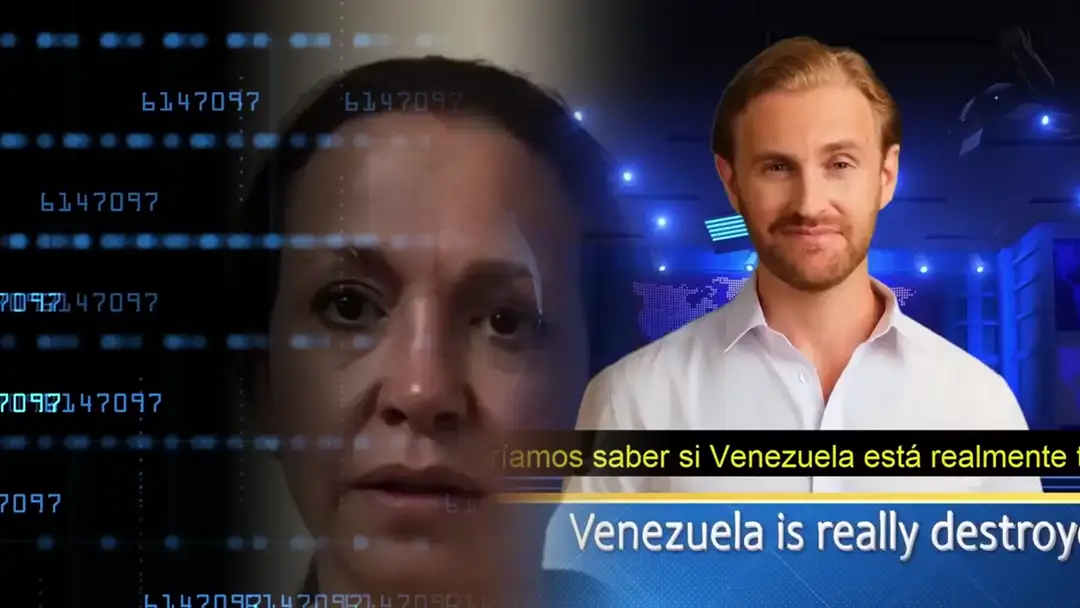

Venezuela no está aislada de este avance tecnológico y la preocupación por el aumento de contenidos generados con inteligencia artificial supone riesgos reales para el impulso y posicionamiento de narrativas desinformantes. Uno de los primeros usos de la IA para desinformar detectados por Cazadores de Fake News fue “House of News”, un falso noticiero en inglés que fue impulsado por voceros del gobierno como una “prueba” de que los medios estadounidenses comenzaban a reconocer la mejoría económica y social de Venezuela, en contraposición con las “narrativas de las grandes corporaciones”.

Este falso noticiero en YouTube se valía de avatares sintéticos, creados desde la plataforma Synthesia.io, para reseñar la poca disponibilidad de plazas en temporadas vacacionales en el país, entre otros tópicos que se usaron como “prueba” de la recuperación económica y social de Venezuela. Las visualizaciones de este “noticiero” fueron promovidas con el pago de anuncios publicitarios que no fueron declarados como contenido sociopolítico, tal como es exigido por las normas de la plataforma por lo que, eventualmente, el canal fue eliminado de YouTube.

El origen anónimo y los métodos poco transparentes de “House of News” no evitaron que voceros del alto gobierno, comunicadores y medios aliados hicieran eco de sus contenidos como si se tratara de un noticiero real. Incluso en el canal del estado, Venezolana de Televisión, se transmitieron videos publicados en el canal, con el fin de reforzar la narrativa de la “evidente” recuperación de Venezuela.

Un caso que raya en lo pintoresco es un deepfake —video o imagen sintética creada con IA basada en aprendizaje profundo— que utilizó Luis Ratti para desprestigiar a María Corina Machado, entonces candidata a las primarias opositoras. Aprovechando un sistema de animación de imágenes estáticas como MyHeritage, generalmente empleado para “volver a la vida” fotografías antiguas de ancestros de los usuarios registrados en esa plataforma, Ratti presentó un supuesto video de la líder opositora en la que —según él— se veía bajo los efectos del fentanilo, la llamada “droga zombie” que azota a Estados Unidos. La fotografía que usó para esta manipulación digital, ha estado publicada en Internet desde el 2018 y corresponde a la denuncia hecha por Machado luego de que una turba la atacó en su recorrido por Upata, estado Bolívar.

Aunque no es posible comprobar que Ratti es el autor de la animación, sí fue de los primeros usuarios en publicarlo en redes sociales, lo que aceleró su viralización. Este tipo particular de manipulación digital, a pesar de ser relativamente rudimentaria, sirvió a los desinformantes para reforzar narrativas que buscaban desprestigiar a la principal candidata y del proceso de primarias opositoras en general.

En contraposición con este producto, también fue detectado otro deepfake mucho más elaborado y en otro formato: un video que contenía un audio generado con IA en el que la locutora y comediante Verónica “La Vero” Gómez, aparentemente se negaba enfáticamente a hacerle publicidad a Machado y a Henrique Capriles, también candidato a las primarias. El video, que circuló en Instagram, Twitter y YouTube, simulaba ser un fragmento de la conversación en el estudio del programa “Fuera de Forma” que “salió al aire por error”.

Este bulo fue difundido por una red de falsos noticieros en Instagram que Cazadores de Fake News identifica como «La Fábrica de Desinformación» y fue amplificado por el portal desinformativo Venezuela News. Sin embargo, la organización considera que la imitación de la voz de la locutora fue creada de forma sintética mediante inteligencia artificial generativa, probablemente con el método Retrieval-based Voice Conversion (RVC).

Verificación de la IA

La proliferación de deepfakes resalta la urgencia de adoptar medidas preventivas y herramientas de verificación como HiveModeration, AIorNOT y AI Speech Classifier para discernir entre contenidos auténticos y aquellos generados por IA. Sin embargo, estas herramientas, ya accesibles en línea, no son infalibles y han demostrado tener márgenes de error significativos, con falsos positivos y negativos en situaciones reales, observación confirmada en varias ocasiones por Cazadores de Fake News.

A medida que la tecnología de IA generativa avanza rápidamente, las herramientas de verificación actuales se quedan atrás, lo que sugiere que los errores en la detección serán cada vez más comunes.

Precisamente, este fue el reto ante la verificación de una imagen publicada por la embajada de Israel en Panamá, en la que mostraba a un grupo de jóvenes que viajaba de Israel a Panamá a defender a ese país del ataque de Hamás.

Varios participantes de Community Notes, la comunidad de verificación ciudadana de Twitter/X, detectaron un grupo de “artefactos” o “glitches” en la fotografía y trataron de comprobar su autenticidad utilizando herramientas para reconocer contenido sintético. Sin embargo, las herramientas produjeron falsos positivos, lo que aumentó la confusión entre los usuarios y fortaleció la creencia de que la imagen había sido creada con IA generativa. Finalmente, la Embajada de Israel en Panamá aclaró a Cazadores de Fake News que, aunque la fotografía era auténtica, había sido alterada mediante un software de mejora de calidad basado en inteligencia artificial, lo que había llevado al error a las herramientas de verificación utilizadas.

Consecuencias sociales y medidas de verificación

La advertencia de James Cameron sobre los peligros de las tecnologías avanzadas, especialmente el uso de deepfakes para sembrar discordia y desinformación, cobró relevancia en 2023. Es fundamental reconocer la importancia de las herramientas de generación de contenido a través de IA y la necesidad de adoptar un enfoque integrado en el análisis de sus productos para garantizar su verificación efectiva y precisa.

La concienciación sobre la existencia de estas herramientas y su aplicación se vuelve crucial para combatir la propagación de contenidos generados artificialmente. Sin embargo, la lucha contra las interrogantes éticas planteadas por la IA en la creación de contenido exige consenso entre expertos técnicos, legales y comunicacionales, pero resalta la necesidad imperiosa de alfabetizar tecnológicamente a los usuarios: enseñarles a discernir entre contenido auténtico y generado por IA se perfila como la estrategia más efectiva para contener la desinformación.

Cazadores de Fake News investiga a detalle cada caso, mediante la búsqueda y el hallazgo de evidencias forenses digitales en fuentes abiertas. En algunos casos, se usan datos no disponibles en fuentes abiertas con el objetivo de reorientar las investigaciones o recolectar más evidencias.